一日一技:Requests被网站识别怎么办?

现在有很多网站,已经能够通过JA3或者其他指纹信息,来识别你的请求是不是Requests发起的。这种情况下,你无论怎么改Headers还是代理,都没有任何意义。

我之前写过一篇文章:Python如何突破JA3,但方法非常复杂,很多初学者表示上手有难度。那么今天我来一个更简单的方法,只需要修改两行代码。并且不仅能过JA3,还能过Akamai。

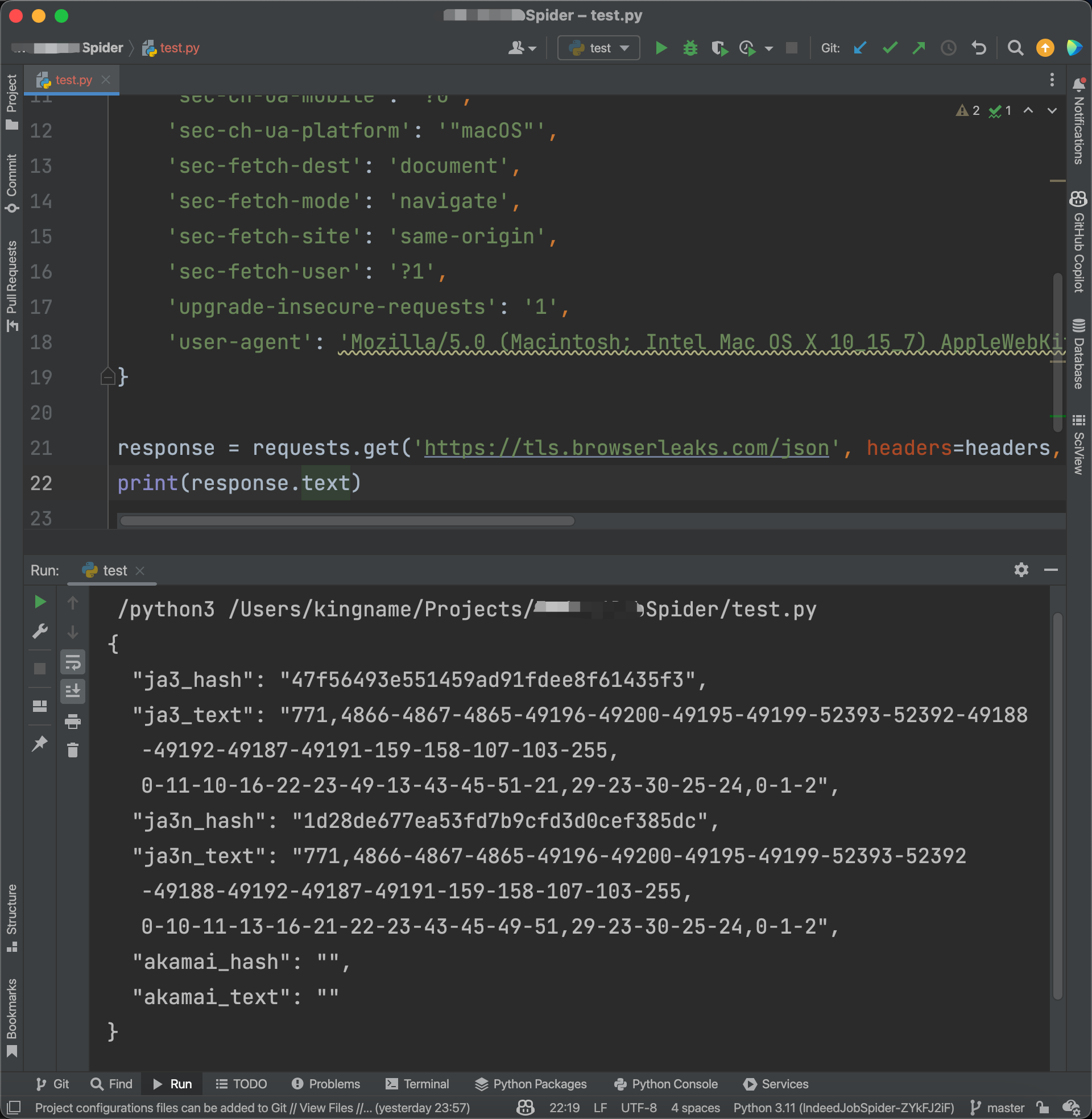

先来看一段代码:

1 | import requests |

运行效果如下图所示:

这是直接使用Requests发起的请求。你可以试一试,加上代理以后,这里的ja3_hash并不会发生变化。并且akamai_hash和akamai_text都是空。这个特征上非常明显的,网站直接根据这些特征就可以屏蔽你的爬虫。

现在,我们使用两行代码解决这个问题。

首先,安装一个第三方库:curl_cffi:

1 | python3 -m pip install curl_cffi |

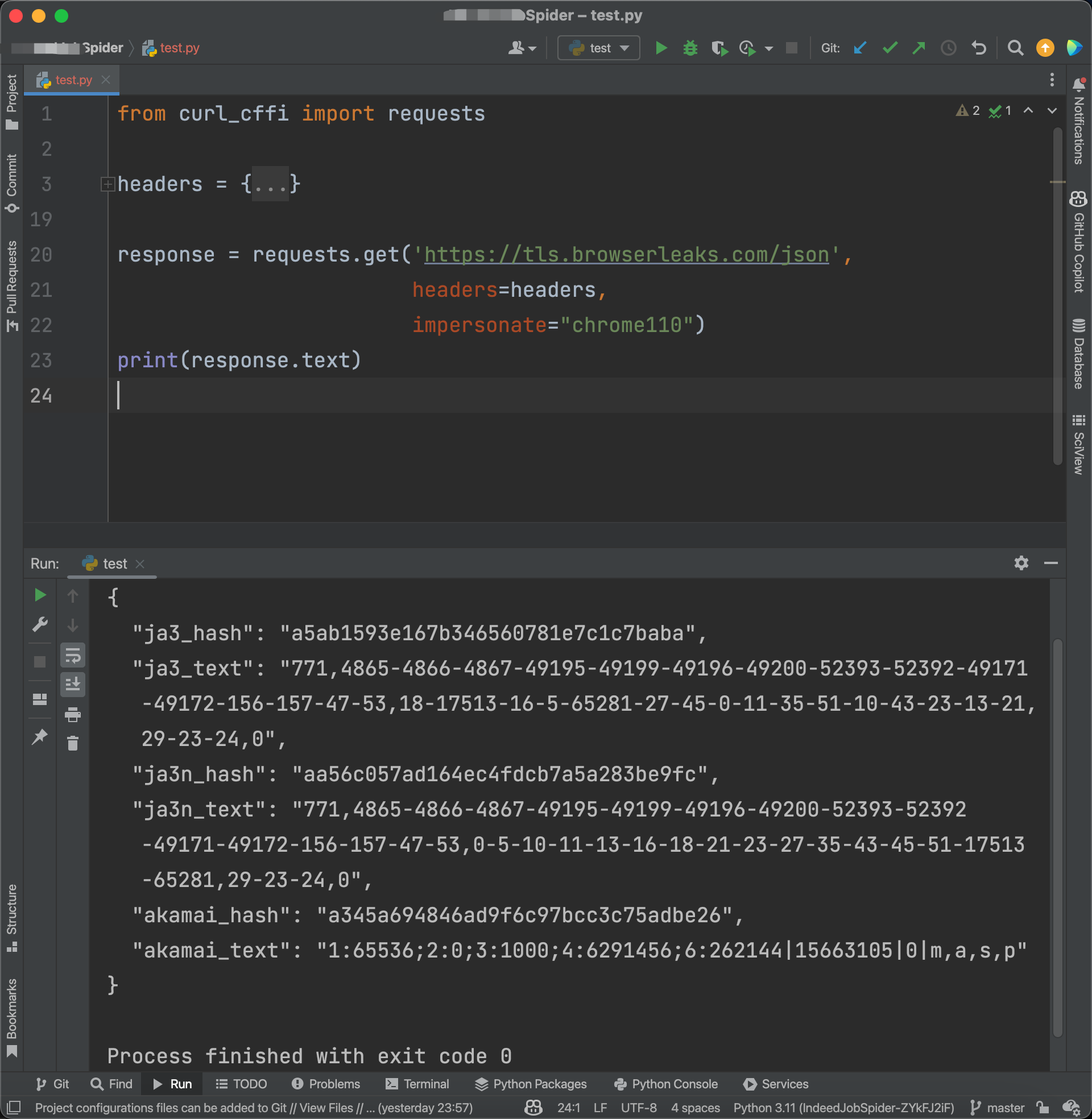

然后,修改我们这段代码的第一行,把import requests改成from curl_cffi import requests。最后,在requests.get中加一个参数:impersonate="chrome110"。完整效果如下图所示:

完成了。以上就是全部修改。网站已经无法识别你的爬虫了。在网站看来,这只是一个Chrome 110版本发起的请求。甚至Akamai需要的签名也都有了。

curl_cffi不仅完全兼容Requests的语法,而且还支持Asyncio。要使用异步写法时,代码如下:

1 | import asyncio |

关于curl_cffi的更多用法,可以查看它的Github:Python binding for curl-impersonate via cffi