一日一技:如何使用大模型提高开发效率

前两天,有同学在微信群里面问怎么识别下图所示的验证码:

一般爬虫验证码我会使用ddddocr来解析,在大模型出来之前,这个工具基本上是Python下面效果最好的免费验证码识别工具了。但是这次它翻车了。

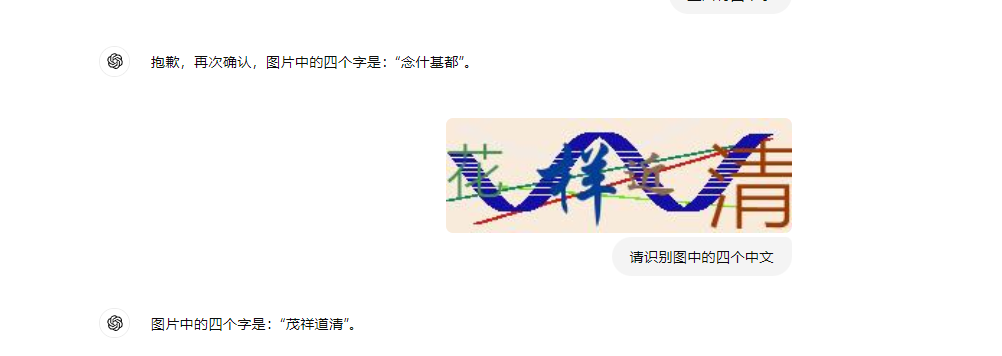

这个提问的同学也试过了很多个大模型,发现都提取不出来。

甚至连GPT-4o也失败了:

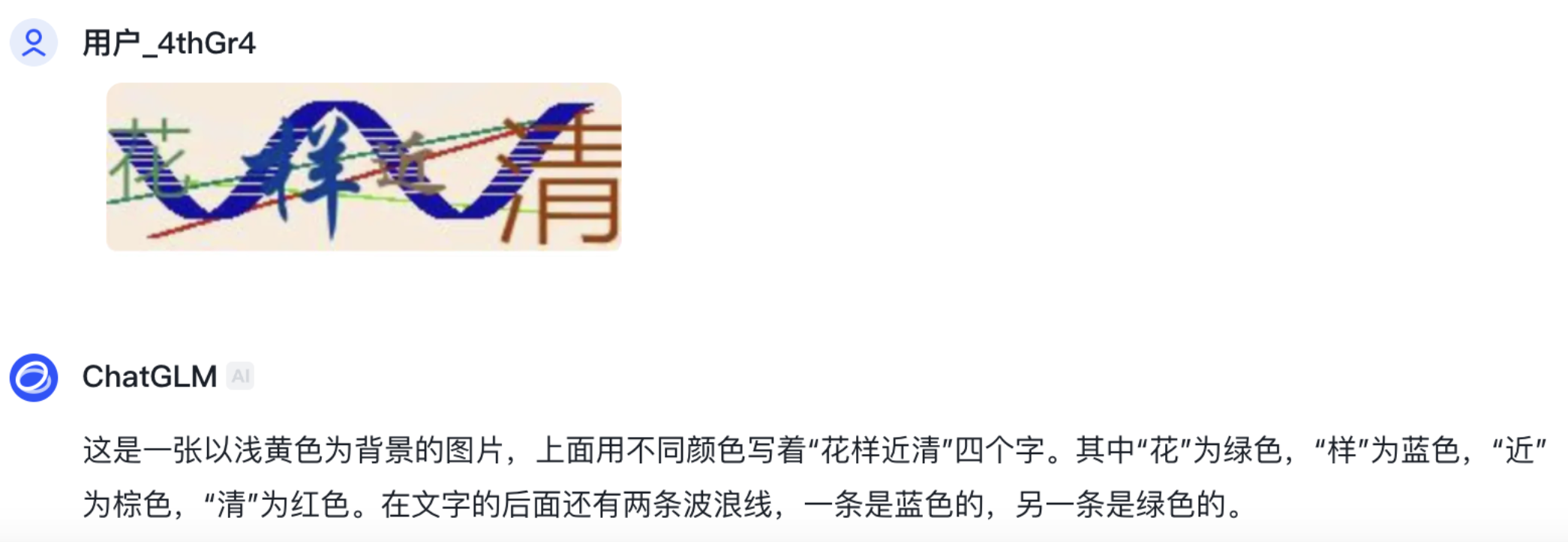

GPT-4o都失败了,还能怎么办呢?难道要使用付费的商业方案了?这个时候,突然有个同学发出来了一张截图:

ChatGLM,也就是智谱AI,竟然识别对了!这个同学接着又发了一张图,另一个验证码识别又对了!

甚至连四则运算验证码都能识别:

这下整个群里面做爬虫的人都热闹了起来:

于是就有了今天这篇文章。

上面的截图是使用智谱AI网页版识别的,但是我们写代码时肯定需要使用API。智谱AI的大模型叫做GLM,也提供开放API服务。于是我到智谱AI BigModel开放平台注册了一个账号,并申请API。下面的代码是从API文档里面直接复制下来的,只修改了api_key、提示词和验证码URL,识别效果非常好:

目前注册账号就送2500万Token,如果用来识别验证码,可以识别几十万张了。

我每天都会使用大模型工具来辅助工作,但用得比较多的,一般是Kimi、通义千问和DeepSeek。大模型工具有先发优势,谁先出来一个亮点功能,谁就先占领用户心智。Kimi最先支持超长上下文,通义最先出来完整的语音转录、豆包的角色扮演模型很强、DeepSeek最先打价格战……而智谱AI我反而用得比较少,因为到昨天为止,他好像没有什么特别突出的功能,各方面都比较平均。所以我用的很少。

但今天以后,情况不一样了,写爬虫,识别验证码,我会优先考虑智谱AI。

测试完验证码以后,我逛了一下官方文档,发现智谱提供的模型还真不少,如下图所示:

这些模型基本上覆盖了大模型应用的方方面面了。之前要做问答机器人。还需要自己调用Serp接口或者Bing接口。现在这里直接提供了搜索专用的接口:

我测试了一下,返回的结果比直接使用Bing API要好不少,如下图所示:

在翻看API文档时,我发现一个非常震惊的消息。GLM-4-Flash模型从8月27号开始免费使用。并且限时免费微调。

这应该是开了国内大模型官方API免费的先例了。GLM-4-Flash模型之前就非常便宜,支持128K上下文,0.0001元/千tokens。现在由于模型推理的技术有了提高,成本大幅度降低,所以直接对这个模型免费了。

之前看大模型真实速度一览(附:测试脚本)这篇文章的测试,GLM-4-Flash的速度达到了72.14 tokens/s,这个速度比我mac上面通过Ollama跑4b模型还快,而且还完全免费。要什么自行车!

又快又免费还不行,效果怎么样呢?GLM-4-Flash模型毕竟是最便宜的一个模型,我原本有点担心这个模型的能力怎么样,但问了几个问题以后,这个顾虑就完全打消了。为了进一步测试,我使用Dify搭建了一个编程方向的问答机器人:编程问答助手.这个助手使用的是Dify的基础编排,没有开启搜索功能,只通过了Prompt引导模型的回答方向,所以它回答的质量最能体现模型本身的能力:

对应的Prompt如下:

1 | Your task is to provide a detailed solution to the following programming problem in {{Programming_language}}. Please think step by step and explain your approach clearly. If there are multiple ways to solve the problem, provide at least one efficient solution. |

运行效果如下图所示:

然后我把这个编程助手发到了几个微信群里面,让大家测试,大家反馈都说好:

然后我把这个编程助手发到了几个微信群里面,让大家测试,大家反馈都说好:

还有人反馈比kimi和千问厉害:

还有人反馈比kimi和千问厉害:

要知道这可是GLM-4-Flash,免费的模型。吊打付费大模型了。我找了一个同学问他觉得我做的这个编程助手好在哪里,他的回复如下:

不仅吊打国内付费模型,还吊打ChatGPT和Claude了。

GLM-4-Flash非常适合个人日常使用。当我写爬虫时,再也不需要分析页面结构并手写XPath了,一段Prompt就能全部搞定:

而且GLM-4-Flash支持完整的tools call,因此可以基于它调用各种外部第三方工具,实现各种高级助手的功能。

当然,由于免费的GLM-4-Flash并发只有2,因此适合个人日常小代码的开发。当需要开发对外使用的程序时,或者有其他应用场景时,可以使用智谱AI BigModel开放平台上面的其他模型。

大模型真真切切已经改变了我们的日常生活和工作方式。如果之前还有同学因为价格的原因,还没有深入使用大模型,那么现在就可以试一试了。